La aplicación AI Edge Gallery, anunciada discretamente a finales de mayo de 2025, se presenta como la primera iniciativa de Google para llevar modelos de IA de código abierto directamente al dispositivo móvil. Según reportes de TechCrunch y el Economic Times, esta nueva herramienta se encuentra en una fase Alpha y está disponible únicamente para Android 10 o superior en dispositivos con al menos 6 GB de RAM y chips modernos, aunque se espera su llegada a iOS en próximas semanas.

Al descargarse desde GitHub bajo licencia Apache 2.0, los usuarios pueden elegir entre modelos como Gemma 3n de Google o variantes de la comunidad en Hugging Face, con capacidad para generar imágenes, responder preguntas, escribir o depurar código, e incluso tareas multimodales. De esta forma, Google busca ofrecer una alternativa para quienes prefieren procesar datos sensibles en el teléfono en lugar de enviarlos a la nube.

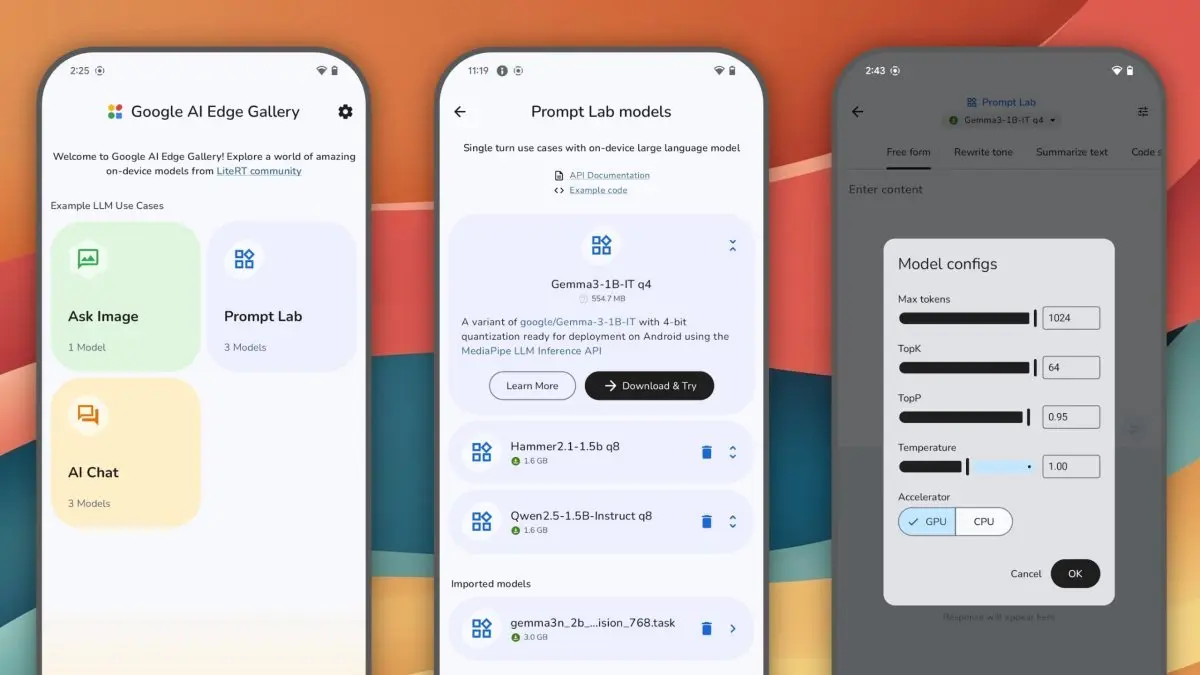

Funciones clave y experiencia de usuario

El menú principal de AI Edge Gallery muestra accesos directos a distintos módulos de IA, entre los que destacan “Ask Image” y “AI Chat”. Al seleccionar una de estas opciones, la aplicación despliega una lista de modelos compatibles para la tarea, incluyendo el propio Gemma 3n, que ofrece un tiempo de respuesta (TTFT) aproximado de 1,3 segundos en un Pixel 8 Pro al ejecutar un modelo de 2 mil millones de parámetros.

Además, AI Edge Gallery incorpora un espacio denominado Prompt Lab, donde los usuarios pueden probar “tareas de un solo turno” (single-turn), como resumir o reescribir textos, mediante plantillas preconfiguradas y parámetros ajustables. Esta herramienta no solo facilita la personalización de la experiencia de IA, sino que también fomenta la experimentación para desarrolladores e investigadores que deseen importar sus propios modelos en formato LiteRT.

Requerimientos técnicos y rendimiento en dispositivos

Para garantizar un desempeño fluido, Google recomienda instalar AI Edge Gallery en dispositivos con Android 10 o superior, un mínimo de 6 GB de RAM y procesadores recientes—como la serie Snapdragon 8 Gen 3 o los Tensor G4 de Google. La aplicación emplea el runtime LiteRT, optimizado para diferentes configuraciones de hardware y capaz de desplegar modelos complejos sin conexión a Internet.

No obstante, Google advierte que el rendimiento variará según la potencia y el tamaño del modelo: cuanto mayor sea el número de parámetros—por ejemplo, superiores a 4 mil millones—, más latencia se percibirá. Aun así, los primeros benchmarks muestran que incluso modelos medianos pueden responder en pocos segundos en dispositivos tope de gama.

Privacidad y ventajas del procesamiento en dispositivo

Uno de los principales valores añadidos de AI Edge Gallery es su enfoque en la privacidad: al ejecutar los modelos íntegramente en el smartphone, los datos del usuario no se envían a servidores remotos, reduciendo el riesgo de filtraciones o vigilancia no deseada. Además, al no depender de conexión a Internet, la app resulta útil en zonas sin cobertura o para quienes prefieren un uso offline.

Este planteamiento también favorece la rapidez en la respuesta, ya que evita la latencia inherente al envío de solicitudes a la nube. Usuarios y especialistas en seguridad informática han destacado que el hecho de procesar localmente modelos como Gemma 3n—capaz de generar imágenes, redactar textos y responder consultas—supone un gran avance para aplicaciones de asistente personal, edición de fotos y soporte al desarrollo de software directamente desde el móvil.

Perspectivas de desarrolladores y adopción futura

Google ha invitado a la comunidad de desarrolladores a aportar feedback sobre AI Edge Gallery, resaltando su naturaleza open-source y su licencia Apache 2.0, que permite usos comerciales y experimentales sin restricciones. Los desarrolladores pueden crear o adaptar modelos LiteRT y compartirlos en repositorios compatibles, ampliando gradualmente la biblioteca de modelos disponibles.

Se espera que, en las siguientes actualizaciones, la aplicación incorpore modelos de mayor tamaño y mejore la interfaz de usuario, así como añada soporte para iOS. También existe la posibilidad de integrar audio y otras capacidades multimodales, siguiendo la tendencia de la IA generativa en dispositivos móviles. Con el tiempo, Google podría habilitar flujos de trabajo específicos para sectores como salud, educación o marketing, donde la IA sin conexión suponga una ventaja competitiva.